משתמשים ב-AI בלי לבדוק את האבטחה? אתם מסכנים את העסק שלכם

- רותם שיינס

- 12 במאי 2025

- זמן קריאה 3 דקות

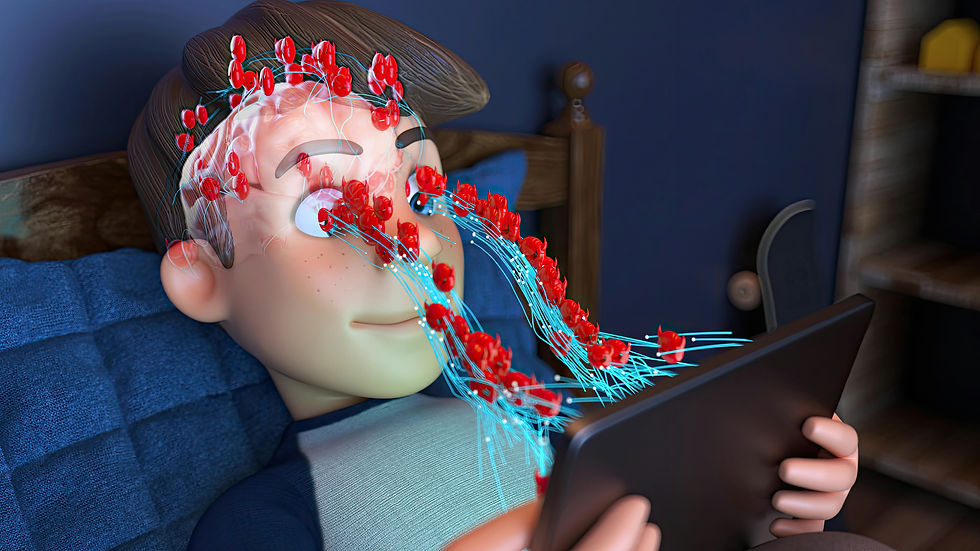

בעידן של היום, שירותי מחשוב מסורתיים עוברים שינוי מהותי. במקום תהליכים ידניים והרצת תוכנות מוגדרות מראש, אנחנו רואים יותר ויותר כלים מבוססי בינה מלאכותית שפועלים באופן עצמאי, מבצעים משימות מורכבות, ולפעמים גם מקבלים החלטות – ללא מעורבות אנושית ישירה.

כמומחה לאבטחת מידע ולפתרונות AI, אני יכול לומר בביטחון: מדובר במהפכה. אלגוריתמים של AI מנהלים היום מסדי נתונים, נותנים שירות לקוחות, מפיקים דוחות, מנתחים נתונים – ואת כל זה הם עושים מהר, מדויק, ובעיקר – לבד.

אבל כמו כל מהפכה טכנולוגית, גם זו מביאה איתה הזדמנויות – וגם סיכונים.

הבעיה: מה אנחנו מקריבים למען היעילות?

אחת הסכנות הגדולות ביותר היא דליפה של מידע רגיש.

כלי AI עובדים עם כמויות עצומות של מידע – אישי, עסקי, פיננסי – וזה מה שהופך אותם למטרה מפתה להאקרים. ראינו את זה קורה כבר כמה פעמים:

במרץ 2023, תקלה ב-ChatGPT גרמה לחשיפת פרטי משתמשים – שמות, מיילים, פרטי כרטיס אשראי.

מעל 101,000 חשבונות הודלפו מהמערכת והוצעו למכירה בדארק-ווב.

וזה עוד לפני שדיברנו על שימוש לא מודע או לא אחראי של עובדים בכלי AI.

למשל: עורך דין שמזין בטעות פרטי לקוח לשירות מבוסס AI לצורך ניסוח מייל. הכוונה טובה – התוצאה עלולה להיות הרת אסון אם המידע נשמר על ידי המערכת.

זו בדיוק הסיבה שחברות ענק כמו Amazon ו-JP Morgan בחרו לחסום לחלוטין את הגישה ל-ChatGPT מתוך הארגון.

!AI כפלטפורמה לתקיפה

אבל הסיפור לא נגמר בזה. בינה מלאכותית היא לא רק מטרה – היא גם כלי תקיפה.

פושעים משתמשים היום בכלים כמו ChatGPT כדי ליצור אימיילים מזויפים (phishing) שנראים אמיתיים מתמיד. בוטים יכולים לחקות סגנון דיבור של מנכ"ל, ליצור מסמכים מזויפים ברמה גבוהה, ואפילו לשכפל קולות אנושיים כדי לבצע הונאות טלפוניות.

היכולת הזו לשחזר "אנושיות" ברמת דיוק גבוהה – זו כבר לא טכנולוגיה עתידנית. זו מציאות.

האחריות עלינו

אני תמיד אומר ללקוחות שלי: הכלים האלה חזקים – אבל הם רק כלים. האחריות היא שלנו, המשתמשים.

אם אתם בעלי עסקים, מנהלים, או אפילו משתמשים פרטיים – אל תתנו אמון עיוור. כל מה שאתם מקלידים למערכת, כל מה שאתם משתפים עם בוט – עלול להישמר, לעבור הלאה, או אפילו לשמש נגדכם.

לכן, הנה כמה כללים פשוטים שאני ממליץ עליהם לכולם:

6 טיפים לשימוש בטוח בכלי AI

אל תשתפו מידע רגיש. שום תעודת זהות, פרטי אשראי, או מסמכים סודיים. נקודה.

בדקו את תנאי השימוש. האם הכלי שומר את הנתונים שלכם? האם הוא משתמש בהם לאימון? קראו לפני שאתם מקלידים.

אבטחו את החשבונות. סיסמה חזקה ואימות דו-שלבי – חובה.

בחרו כלים מאובטחים. תעדיפו שירותים מוכרים, עם הצפנה, תיעוד ברור ובקרות גישה (RBAC).

הדריכו את הצוות שלכם. הסבירו לעובדים מה מותר להזין למערכת – ומה אסור בהחלט.

הפעילו שיקול דעת.

דוגמה מהשטח

במאי 2023 תוקף זיהה פגם באחת מהספריות בהן השתמשה OpenAI וחשף שיחות של משתמשים שונים זה בפני זה. פרצות נוספות התגלו במערכות Redis שעליהן פועל חלק מהשירות – והנזק הפוטנציאלי היה עצום.

והכי מטריד? רוב המקרים לא נגרמים מהאקר גאון – אלא ממשתמש רגיל שהזין את המידע הלא נכון למקום הלא נכון.

לסיכום

בינה מלאכותית לא הולכת להיעלם – להפך, היא תהיה רק יותר נפוצה. היא עוזרת לנו להתייעל, לחסוך זמן, לחשוב טוב יותר.

אבל היא גם דורשת מאיתנו להיות זהירים יותר, אחראיים יותר, ולשים את נושא האבטחה בראש סדר העדיפויות.

אני מזמין אתכם לקרוא עוד על שימוש בטוח ויעיל בטכנולוגיות AI – וליצור איתנו קשר להתייעצות מקצועית: https://cybertis.co.il

.png)